誤判病情 混淆謬論 資料洩漏 人工智能問診 存在風險隱憂

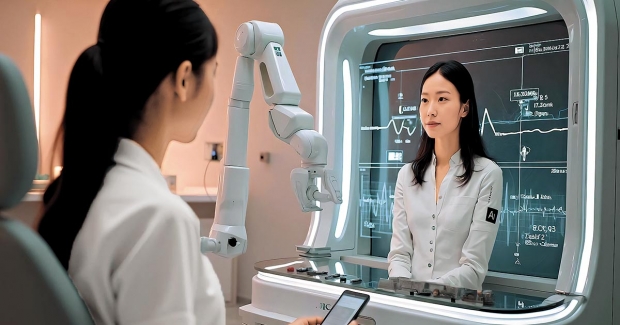

科技進步讓人工智能(AI)無處不在,從導航到網購皆然。近年,「生成式AI」(Generative AI)如ChatGPT、Gemini等興起,不少香港市民利用這些AI解答健康問題,例如喉嚨痛、藥物副作用等,猶如「健康顧問」。然而,AI問診是便利還是另有風險?我們應如何理性看待這新技術?

生成式AI能夠模擬人類語言,以對話方式回答問題,甚至根據症狀建議診斷。引用著名科普雜誌《科學人》(Scientific American)報道的研究顯示,早期生成式AI GPT-3在症狀分析中,能在88%的情況下將正確診斷列入前三項可能結果,雖略遜於醫生的96%,但遠超傳統線上工具的51%。在醫療資源緊張的香港,這種快速、免費的健康指引備受矚目。

AI問診的吸引力顯而易見。半夜突然發燒,只需用手機輸入症狀,AI便能即時分析病因並建議是否需要求醫,毋須翻查不同網站或等待電話熱線。疫情期間,線上醫療需求激增,有機構已採用簡單的聊天機械人處理預約或提供資訊,而生成式AI更為先進;耶魯大學的研究顯示,Google的醫療AI Med-PaLM答題與醫學共識的吻合度達92.6%,幾乎與醫生(92.9%)不相上下,引發公眾對AI成為未來問診常態的期待。

遺漏關鍵細節

在問診方面AI雖方便,但風險不容忽視。研究顯示,AI診斷準確性高,但通常基於完整且標準化的症狀描述。現實中,市民可能描述不清或遺漏了關鍵細節,例如忘記提及慢性病史或藥物過敏,容易導致誤判。有專家警告,AI無法針對個別患者進行全面健康風險評估,例如判斷胸痛是否需要急診。如公眾過分依賴AI處理急症或複雜病情,可能延誤治療,後果嚴重。

其次是AI的資訊來源亦令人擔憂。生成式AI依賴互聯網數據,雖包含醫學文獻,但也可能混雜不可靠來源,例如社交媒體上的健康謠言。《科學人》指出,AI可能將權威資訊與網絡謬論混淆例如疫苗謬論,導致作出誤導性建議。此外,AI有時會有「幻覺」效應(Hallucination),生成看似合理但錯誤的內容,例如耶魯大學醫生測試發現,AI撰寫的鴉片類藥物論文引用了不存在的來源。在醫療領域,這類錯誤若被公眾誤信,可能帶來嚴重後果。

數據更新速度也是AI的一大隱憂。部分AI平台的數據滯後可能長達數年,無法反映最新醫療進展,例如新藥或最新的治療指引。醫療知識不斷進步,AI若跟不上,其建議可能失準。相比之下,搜尋引擎如Google雖有局限,但資訊來源較透明,市民可自行選擇可靠來源,例如香港衞生署網站或美國疾病管制與預防中心(CDC)的健康資訊,與AI形成互補。

此外,AI問診可能加劇醫療偏見。不少互聯網數據及意見帶有性別或族群偏見,麻省理工學者警告,AI在處理數據時可能複製這些資料。例如,ChatGPT曾對女性或少數族群的症狀描述給予不同「權重」,導致建議失準。這可能影響市民求醫決定,加劇醫療不公。

私隱問題同樣令人關注。使用AI模型有時需提供電郵或電話等個人訊息,描述症狀時也可能洩露家族病史等敏感資料。有專家指出,AI的友善語氣易讓用戶放鬆警惕,分享過多訊息;OpenAI表示,ChatGPT會收集用戶位置和IP地址,若數據洩露,可能帶來風險,尤其在重視私隱的香港。

適合教育用途

香港市民應如何安全使用生成式AI獲取健康資訊?首先,AI適合教育用途,如解釋醫療術語或疾病診斷流程,而非用於診斷。提問應具體,例如「這藥有何作用?」「這檢查的風險是什麼?」避免高風險、需臨床判斷的問題(如症狀診斷);其次,對AI答案保持懷疑,交叉查證香港衞生署等權威來源,因AI資訊來源不透明且可能缺乏參考依據,切勿全信,若遇到急症或嚴重症狀,應立即求醫,切勿依賴AI。

儘管香港醫療系統資源緊張,AI可助處理簡單查詢,減輕醫生壓力,讓他們專注複雜病例,但引入AI問診需解決數據私隱、偏見及誤診責任等問題,監管機構和醫療界必須共同確保技術安全可靠。

生成式AI為市民提供便捷的健康資訊途徑,潛力巨大,但風險不容忽視。市民應理性地使用AI,善用其教育功能,謹慎查證答案,避免產生不必要擔憂。健康第一,AI再「聰明」,也無法取代醫生的專業判斷與關懷,讓我們謹慎擁抱這場科技與醫療的融合。

撰文 : 譚仲豪醫生

[信健康] 淺談AI提供健康資訊,醫生資訊要留意!【更多健康資訊:health.hkej.com】