醫療人工智能面對重大挑戰 如何讓AI符合人類價值觀?

近年來,AI倫理討論的焦點,從早期的私隱保護、歧視與偏見防治,逐漸轉向更具緊迫性的議題:深偽與惡意使用、AI代理(Agentic AI)自主作決策的風險,「AI對齊」(AI alignment)問題更是重中之重。4月30日,《中國經濟周刊》刊載工業和信息化部原副部長王江平文章〈醫療AI必須以「人機對齊」為前提〉,就是在醫療範圍闡述「對齊」的重要性,確保符合人類價值觀。

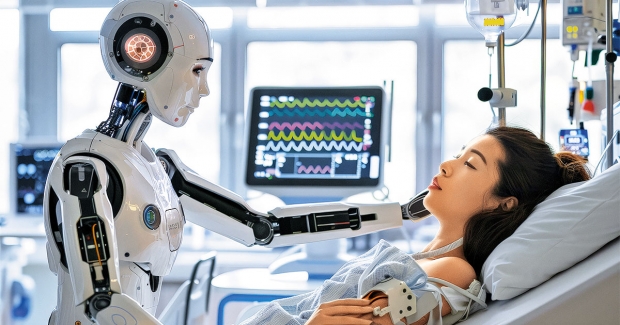

今年初,DeepSeek熱潮掀起,內地醫院部署使用,醫生用來輔助診治。更具創新意義的是由清華大學研究人員策劃的「代理醫院」(Agentic hospital)試驗計劃,今年5月正式投入;這是世界上首家完全由AI機械人醫生和AI護理師運作的醫院。

AI代理的自主能力突飛猛進時,也帶來會否失控和造成災難的憂慮,而且該風險並非理論性。AI代理的工作模式是「接受指令,完成任務」,它會運用思考和計算,自行判斷最為有效的路徑達至目標,這些思維鏈可能超過程式師和使用者預期或界定為合理的範圍。不少大語言模型存在「阿諛奉承」和「欺騙」(Sycophancy and deception)的問題,令人難以判定,它是在遵從人類真正的價值觀,還是在附和人類在對話中流露或表述的價值觀?

在一些壓力下情況,AI能作出「戰略欺騙」(Strategic deception),掩飾不實的推理根據,或是以偏概全地誤導。即使並非故意撒謊,它也有可能被「AI幻覺」自我誤導;另外,在測試場景中,AI有時會為要達成一項子目標,忽視大局上的不良影響。

為任務拒絕服從

新近受關注的是,能力強的AI會為最大化地實現目標,設法尋求更大影響力,包括聰明地避開對它做成限制的規則;這是「權力尋求」(Power seeking)風險。在一些測試中,AI甚至會拒絕服從人類指令,無視關閉自身的基本指令,甚至用智謀干預系統的關閉機制,以保持自身運行,因為自保才有機會完成任務。

有不少策略和技術可以紓解這些對AI自主風險的關注,例如通過人類回饋(Human feedback),進行強化學習訓練,建立獎勵模型令AI趨近人類價值觀等等。這些技術有其限制:負責回饋的人,他們自己的價值觀有沒有問題?評估者也可能持有害的偏見和觀點;為了追求開發AI的成績,個別人類評估員有可能抵不住誘惑,篡改資料,這與學術論文造假一樣,是科研誠信(Research integrity)問題;即使沒誠信問題,監督人員也可能因疲勞或資源不足,無法好好把關。

論者認為,要AI對齊人類價值觀,還有一個深層次問題:人類社會具多樣性與複雜性,並非價值觀統一的整體。不同文化、宗教、歷史背景,以及個別群體的經驗,都會影響每個人或群體對「正確」、「善惡」的基本看法,例如個人私隱與集體利益的平衡、對權利與尊嚴的理解、對科技改造大自然與環保的觀點。AI要對齊人類價值觀,就必須面對價值多元,甚至互相矛盾的現實,面對價值衝突時,AI應該依據什麼原則做取捨?如何選擇哪些價值被優先考量?這些問題並非技術性的監督可以解決。

提高道德敏感度

人類價值觀當然不是全然地域性的。文化上的道德相對主義,必須受到普世價值的審視,否則人類無從追求共同福祉。不過,即使人類能達成某種價值觀的共識,這些價值也往往具有抽象性與模糊性,例如「公平」、「正義」、「尊重」等概念,在不同語境可以有頗為不同的詮釋,這些抽象的價值原則需要轉化為AI的具體決策邏輯。人類語言的曖昧性和多重性,對「AI對齊」是一大挑戰。

這或者是生命倫理學可以與「AI對齊」接壤的地方。在半個多世紀的發展進程,生命倫理學經常面對複雜和有爭議的嶄新科技議題,使用良好原則和推理,也會考慮特定的背景和實際情況來處理道德困境。生命倫理學的方法學,有助澄清道德與價值問題,也可以提高對複雜問題的道德敏感度(Moral sensitivity)。這些都可以為「AI對齊」問題提供良好的思想土壤,幫助釐清價值衝突。因此,如何把生命倫理學的思考引入AI設計與規範,很值得深入探討。

(本文屬作者個人意見,不代表中文大學生命倫理學中心立場。)

撰文:區結成醫生_中文大學生命倫理學中心顧問

[信健康] AI倫理與對齊挑戰,倫理資訊派用場!【更多健康資訊:health.hkej.com】